Table des matières

-

Pourquoi est-il important de comprendre la différence entre UHD et HDR ?

-

Qu'est-ce que l'UHD LED ?

-

Qu'est-ce que le HDR LED ?

-

UHD vs HDR : lequel a le plus d’impact sur la qualité de l’image ?

-

Les LED UHD et LED HDR peuvent-ils coexister ?

-

Tendances futures : l’UHD et le HDR vont-ils fusionner ?

-

Conclusion : Choisissez la bonne technologie pour améliorer la valeur visuelle

Dans l'économie de l'attention d'aujourd'hui, la qualité visuelle est synonyme d'influence. Que ce soit au cinéma, sur scène, dans les centres commerciaux ou pour le divertissement à domicile, les consommateurs et les acheteurs sont de plus en plus préoccupés par la performance des équipements d'affichage. Dans ce contexte, les LED UHD (Ultra Haute Définition) et HDR (High Dynamic Range) sont devenues deux des technologies les plus discutées. Mais comprenez-vous vraiment leur différence et leur lien ? Comment bien choisir son achat ? Cet article détaille les points clés de ces deux technologies phares, vous aidant à éviter les pièges courants et à choisir le produit le plus adapté.

1. Pourquoi est-il important de comprendre la différence entre UHD et HDR ?

Tendance actuelle du marché : l'essor de la 4K/UHD et l'évolution du HDR

Ces dernières années, la résolution 4K/UHD est devenue la norme sur les téléviseurs milieu et haut de gamme, tandis que la technologie HDR a progressivement migré du marché haut de gamme vers les produits grand public. Selon le cabinet d'études Omdia, le taux de pénétration mondial des téléviseurs 4K a dépassé 70 % en 2024, et les téléviseurs compatibles HDR connaissent également une croissance rapide de leur part de marché.

Idée fausse courante chez les consommateurs : résolution ≠ qualité totale de l'image

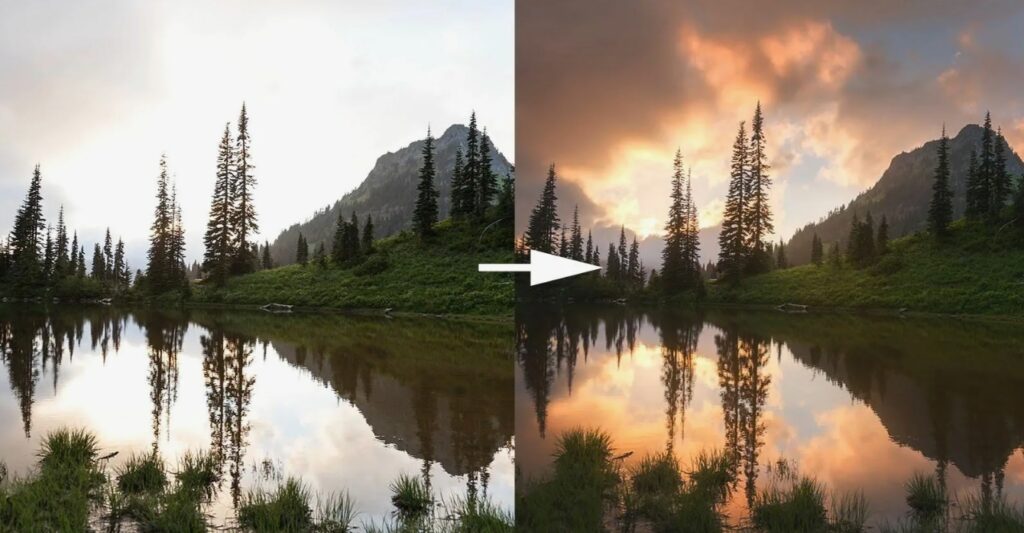

De nombreux consommateurs pensent que le simple fait d'acheter un téléviseur 4K garantit la meilleure qualité d'image. En réalité, la résolution n'affecte que la clarté. La technologie HDR améliore la luminosité, le contraste et la précision des couleurs, rendant l'image plus proche de notre perception du monde réel.

Développement des marchés clés

-

L'UHD (Ultra Haute Définition) est désormais courante. Les écrans 4K sont de plus en plus utilisés dans les écrans LED, en particulier pour la publicité extérieure à grande échelle et les affichages de conférence.

-

Le HDR (High Dynamic Range) se répand rapidement. Les plateformes grand public comme Netflix, Disney+ et Apple TV prennent pleinement en charge les contenus HDR.

-

De plus en plus d’écrans LED prennent désormais en charge la combinaison UHD + HDR, offrant des expériences visuelles immersives.

2. Qu'est-ce que l'UHD LED ?

Définition de l'UHD

L'UHD (Ultra Haute Définition) fait référence à des résolutions d'affichage nettement supérieures à la norme 1080p (Full HD) traditionnelle, comprenant principalement :

-

4K UHD : 3 840 × 2 160 pixels (norme grand public)

-

8K UHD : 7680×4320 pixels (encore en phase d'adoption)

Dans le monde des écrans LED, cela se traduit par des pas de pixels beaucoup plus serrés (par exemple, P1,5, P0,9), particulièrement adaptés à une visualisation rapprochée, comme dans les salles de réunion ou les arrière-plans des studios de diffusion.

Avantages et applications des LED UHD

-

Salles de conférence/studios : la haute résolution garantit des détails d'image précis.

-

Publicité dans les centres commerciaux : capable d'afficher des visuels complexes tels que des publicités 3D et du contenu animé ultra-HD.

-

Performances en direct : prend en charge les divisions multi-écrans, conservant une haute résolution sans distorsion.

3. Qu'est-ce que le HDR LED ?

Définition du HDR

Le HDR (High Dynamic Range) étend la plage de luminosité, de contraste et de profondeur de couleur. Il éclaircit les zones claires et les zones sombres, tout en conservant davantage de détails. Quelle est la différence entre le HDR et le SDR sur les écrans LED ?

Indicateurs clés de la qualité d'image HDR

-

Luminosité maximale : les téléviseurs HDR haut de gamme peuvent atteindre plus de 1 000 nits (les téléviseurs SDR standard atteignent environ 300 nits).

-

Rapport de contraste : les technologies OLED et Mini LED permettent d'obtenir un contraste presque infini.

-

Large gamme de couleurs : prend en charge les normes DCI-P3 ou BT.2020, offrant des couleurs plus riches.

Normes HDR courantes

-

HDR10 : la norme la plus utilisée et la plus prise en charge.

-

HDR10+ : inclut des métadonnées dynamiques pour une optimisation scène par scène.

-

Dolby Vision : HDR haut de gamme avec le rendu des couleurs et de la luminosité le plus précis.

-

HLG (Hybrid Log Gamma) : Principalement utilisé pour la diffusion télévisée.